embedding和onehot、embedding和onehot可以连在一起吗

Item Representation Learning for each node , onehot representation Sequence Representation LearningIt was found that simple meanpooling could already achieve comparable performance compared with attention。

特征的编码直接用onehot会有问题,就像上边提到的,高纬稀疏不利于后面的处理,所以大部分的CTR预估模型都会对onehot特征进行embedding压缩编码的方式有神经网络模型nnlm, word2vec矩阵分解MF因子分解机。

Embedding输出=输入*Embedding,相当于按输入onehot码在Embedding权重矩阵中查表,得到一个与输入对应的向量该向量在nlp中可以用作词向量,与onehot相比,该词向量尺寸更小并且可以表达词之间的逻辑关系,词向量之间的夹角。

编码前和编码后的变化类似图中所示上图对应编码前,下图对应编码后mask_to_onehot 用来将标签进行onehot, onehot_to_mask 用来恢复onehot,在可视化的时候使用方法一在使用的时候需要先定义好颜色表palette。

将汉字表示为 OneHot 的形式 在每行末尾加上 符号是为了标识这首诗已经结束,说明 符号之前的语句和之后的语句是没有关联关系的,后面会舍弃掉包含 符号的训练数据 puncs = #39#39, #39#39, #39#39, #39#39, #39#39, #39。

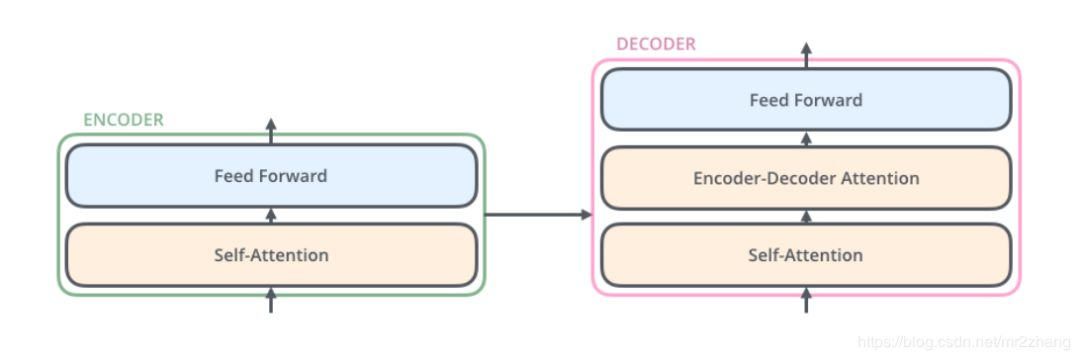

可以看见两者的结果是一样的,所以猜测embedding内部就是先将句子中每个词的索引表示转化为onehot表示,然后对编码后的数据进行矩阵的变换,其中参数开始是输出化的,后面训练的时候可以用来学习编码后的输出为batch,seq_le。

首先,如果不局限于NN的方法,可以用BOW+tfidf+LSILDA的体系搞定,也就是俗称的01或one hot representation其次,如果楼主指定了必须用流行的NN,俗称wordembedding的方法,当然首推word2vec虽然不算是DNN然后。

Embedding在数学上是一个函数,将一个空间的点映射到另一个空间,通常是从高维抽象的空间映射到低维的具象空间Embeding的意义将高维数据转换到低维利于算法的处理同时解决onehot向量长度随样本的变化而变化,以及无法表示。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~