telegeram官方版下载

可视化爬虫框架,python爬虫数据可视化源代码

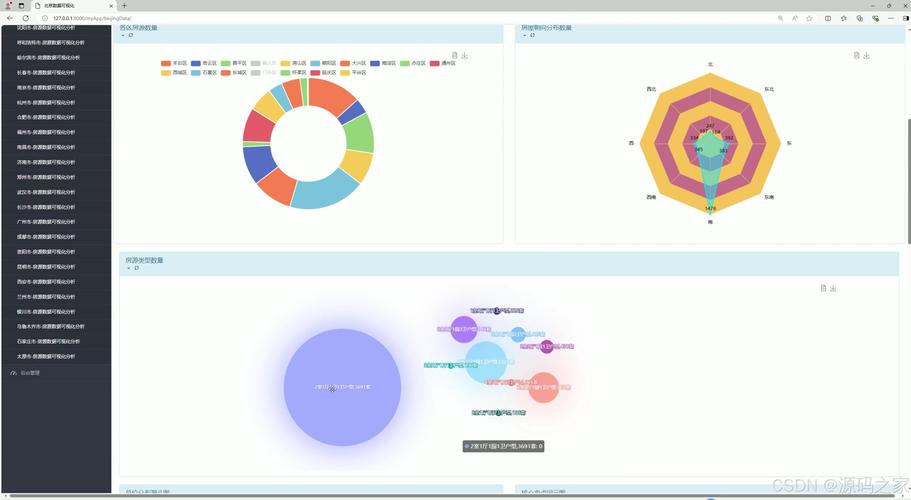

无需编程基础可视化爬虫工具使得非编程人员也能轻松上手,无需掌握复杂的编程语言或框架简化操作流程用户只需通过图形界面设置采集规则,即可实现数据抓取,大大降低了学习成本提高数据抓取效率快速采集数据可视化爬虫工具通常提供预设的采集模板和规则,用户可以快速下载并应用,实现数据的快速抓取。

本文介绍一款Java的可视化爬虫项目,其命名为Spiderweb项目在Gitee平台开源,旨在提供一种流程图方式定义爬虫的平台,实现高度灵活且可配置的爬虫功能Spiderweb项目采用的系统源码来自于另一个Gitee仓库具体链接已省略,旨在为用户提供一个简单且强大的爬虫工具,使其在开发过程中更加便捷项目的核心功能。

在Python数据分析及可视化领域,掌握爬虫技术是关键之一文章接下来将对PyspiderScrapy两大爬虫框架进行深入解析,旨在帮助开发者提升技能,进行高效数据抓取首先,让我们对两个框架进行简要介绍Scrapy是一个功能强大的框架,支持多线程并行抓取,适用于大规模数据集的抓取任务Pyspider则是一个基于分布式。

说实话感觉大同小异各有优缺点吧~常见python爬虫框架1Scrapy很强大的爬虫框架,可以满足简单的页面爬取比如可以明确获知url pattern的情况用这个框架可以轻松爬下来如亚马逊商品信息之类的数据但是对于稍微复杂一点的页面,如weibo的页面信息,这个框架就满足不了需求了2Crawley 高速爬取对应。

它是很强大的爬虫框架,可以满足简单的页面爬取,比如可以明确获知urlpattern的情况用这个框架可以轻松爬下来如亚马逊商品信息之类的数据2Crawley高速爬取对应网站的内容,支持关系和非关系数据库,数据可以导出为JSONXML等3Portia是一个开源可视化爬虫工具,可让使用者在不需要任何编程知识的。

爬虫框架需要URL页面下载器爬虫调度器网页解析器数据处理 爬虫框架要处理很多的URL,我们需要设计一个队列存储所有要处理的 URL,这种先进先出的数据结构非常符合这个需求 将所有要下载的URL存储在待处理队列中,每次下载会取出一个,队列中就会少一个我们知道有些URL的下载会有反爬虫策略。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~