telegeram安卓官网下载

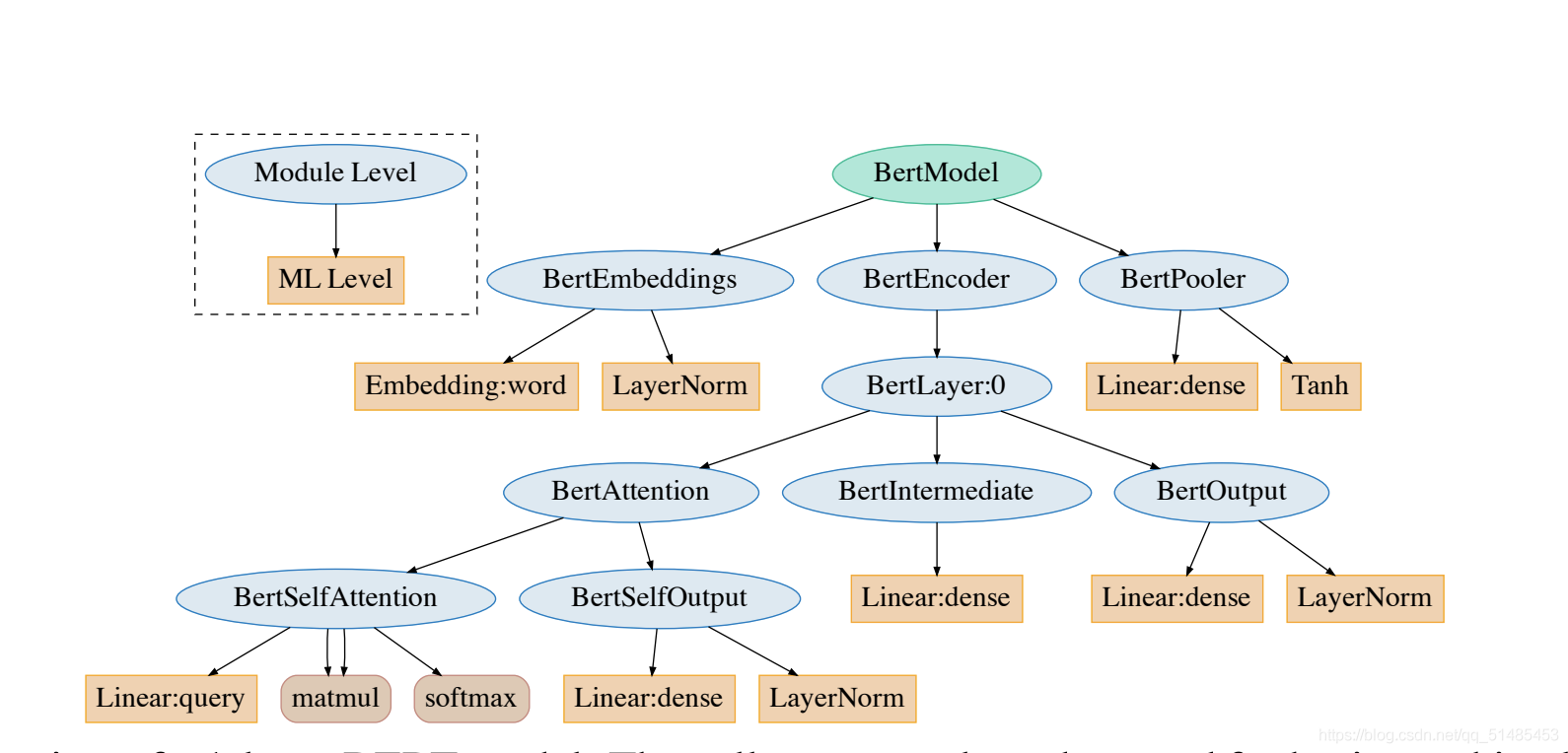

berttokenizer、berttokenizer原理

1、frompytorch_pretrained_bertimportGPT2LMHeadModel,GPT2Tokenizer classPoemGeneratorobjectdef__init__self,model_path,device=#39cpu#39selfmodel=GPT2LMHeadModelfrom_pretrainedmodel_pathselftokenizer=GPT2;与NLP不同,语音信号是连续的,因此很难直接找到类似于BERT预训练的预测标签想要解决这个问题,就需要一个Tokenizer将连续的语音特征映射至离散的标签受文本预训练方法BERT的启发,语音表示学习模型HuBERT 2利用MFCC特征或。

2、有 BertTokenizerFast 和 BertTokenizer, BertTokenizerFast 更快,因为使用了 tokenizer 库因为 tokenizer 库基于 RUST 所以多线程更好而 BertTokenizer 基于 python 的所以,我们使用 BertTokenizerFast from transformer。

3、同样的,输入是wordPiece tokenizer得到的 tokenid ,进入Bert预训练模型抽取丰富的文本特征得到 的输出向量,输出向量过 BiLSTM 从中提取实体识别所需的特征,得到 的向量,最终进入 CRF 层进行解码,计算最优的标注序列 N;情况是 我用 add_tokens方法 添加自己的新词后,BertTokenizerfrom_pretrainedmodel一直处于加载中原因 有说是词典太大,耗时hours才加载出来我也没有真的等到过暂时的解决办法参考于。

4、配置文件中的DIETClassifier则是意图分类的指挥棒,它结合多种特征生成器,如BertTokenizer支持中文分词的rasa_chinese和JiebaTokenizer,以及Sparse和Dense featurizers,共同打造强大的意图识别能力对话策略的交响乐章**对。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~